Surveillance algorithmique

Explorez les dangers de la surveillance algorithmique : comment les algorithmes collectent, analysent et contrôlent nos vies à travers une surveillance invisible mais omniprésente.

PROTECTION DIGITALE

Définition et fonctionnement des caméras algorithmiques

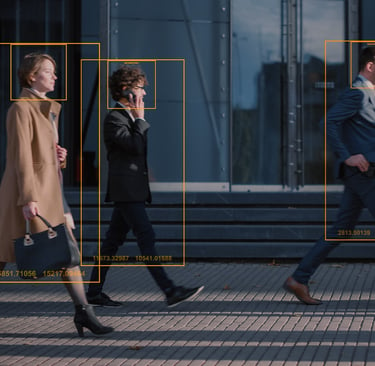

Depuis quelques années, un nouveau type de caméras fait son apparition dans les villes, les gares, les aéroports, les stades ou même certains commerces : les caméras algorithmiques. Contrairement aux systèmes classiques de vidéosurveillance, qui se contentent d’enregistrer passivement des flux vidéo, ces dispositifs sont couplés à des algorithmes capables d’analyser en temps réel les images captées. Le changement est radical : il ne s’agit plus seulement de filmer, mais de comprendre, détecter et prédire.

Le cœur de ce système repose sur l’intelligence artificielle, et plus précisément sur les techniques de machine learning. Grâce à l’analyse de milliers, voire de millions de séquences vidéo, les algorithmes apprennent à identifier des comportements jugés « anormaux » : une personne qui court à contresens dans une foule, quelqu’un qui reste immobile trop longtemps dans un lieu sensible, ou un attroupement qui se forme soudainement. Certains dispositifs vont plus loin, en intégrant de la reconnaissance faciale, des systèmes de lecture automatique des plaques d’immatriculation, ou encore la détection d’objets abandonnés.

Bien évidemment ces nouvelles technologies représentent un business a plusieurs milliards d'euros rien qu'en France, et derrière les sociétés qui développent ces solutions, un grand nombre de lobbyistes s'activent auprès de nos politiques et gouvernements pour augmenter leur part de marché.

Ce traitement ne nécessite même plus l’intervention humaine : le logiciel signale automatiquement une situation, déclenche une alarme ou transmet une alerte aux opérateurs. On parle alors de vidéosurveillance augmentée, où la machine assiste ou remplace la vigilance humaine. En théorie, ces technologies promettent un gain d’efficacité considérable : là où un agent de sécurité ne peut surveiller que quelques écrans, l’algorithme peut balayer des dizaines de flux simultanément, sans fatigue, sans distraction.

Explication sur les dangers de la Video surveillance algorithmique (VSA) par la Quadrature du Net.

Les cas d’usage actuels : sécurité, gestion urbaine, contrôle social

La surveillance algorithmique n’est plus un fantasme de science-fiction : elle est déjà déployée à grande échelle dans plusieurs pays, parfois dans une relative opacité. En Chine, la ville de Shenzhen expérimente des systèmes capables de détecter automatiquement les infractions au code de la route, de suivre des individus dans l’espace public grâce à la reconnaissance faciale, et d’attribuer des points positifs ou négatifs dans le cadre du crédit social. Ces caméras deviennent alors des outils de gouvernance comportementale, récompensant ou sanctionnant les citoyens selon leurs actions.

En Europe, Londres figure parmi les métropoles les plus surveillées, avec plus de 600 000 caméras traditionelles. La capitale britannique a intégré des algorithmes dans son système de vidéosurveillance, notamment pour le repérage d’individus recherchés ou la gestion de la circulation. À Marseille, des expérimentations ont été menées pour détecter les mouvements de foule et repérer des actes suspects dans des lieux à forte densité, comme la gare Saint-Charles ou le Vieux-Port.

Photo Marie Briand-Locu

La surveillance algorithmique a franchi un seuil critique en France avec la loi Jeux Olympiques et Paralympiques (JOP) du 19 mai 2023. Présentée comme une expérimentation limitée dans le cadre des grands événements sportifs, culturels ou festifs, elle autorisait pour la première fois l’usage de traitements algorithmiques en temps réel dans l’espace public. L’expérimentation devait prendre fin le 31 mars 2025, avec une obligation d’évaluation avant toute éventuelle prolongation.

Pendant les Jeux Olympiques, la préfecture de police de Paris et la RATP ont conduit la phase la plus importante de l’expérimentation de la vidéosurveillance algorithmique, conformément à la loi adoptée en mai 2023. Durant deux semaines, les images issues des 485 caméras algorithmiques situées dans la capitale et dans plusieurs communes de la région ont été analysées par Cityvision de la société Wintics, un logiciel d’IA capable de détecter différents comportements : objets abandonnés, chutes, mouvements de foule, etc.

La vidéosurveillance algorithmique a été testée pour la première fois par la police afin de détecter automatiquement un certain nombre de situations anormales en mars dernier en marge du concert du groupe Depeche Mode à Paris. Le ministère de l’Intérieur, via une communication relayée par l’Agence France-Presse, a annoncé l’installation de six caméras équipées du logiciel Cityvision, développé par l’entreprise Wintics. Ces dispositifs seront déployés aux abords de l’Arena de Bercy, dans le 12ᵉ arrondissement de Paris, à l’occasion des concerts prévus sur le site. L’objectif, selon les autorités, est de « tester et configurer les solutions logicielles », sans pour autant recourir à une véritable vidéosurveillance algorithmique. Ce cadre d’expérimentation, conforme à la réglementation en vigueur, permet de valider les performances du système avant un déploiement effectif, tout en évitant la nécessité d’un arrêté préfectoral.

Les entreprises privées aussi y trouvent un intérêt. Certains centres commerciaux ou parkings utilisent ces technologies pour analyser les flux de clients, détecter les comportements de vol à l’étalage, ou encore réguler l’accès aux zones sensibles. Même les écoles ou les hôpitaux commencent à s’équiper, dans un objectif affiché de prévention des violences ou de sécurisation des infrastructures.

Mais derrière ces usages légitimes se dessine un autre usage, moins assumé : celui du contrôle social. À mesure que les caméras deviennent intelligentes, elles acquièrent un pouvoir de surveillance préventive, qui ne se limite plus aux délinquants, mais s’étend à l’ensemble des comportements. Toute personne peut devenir un sujet d’analyse. Un retard inhabituel à la sortie d’une école, un mouvement de foule dans un quartier populaire, une attitude jugée nerveuse dans une gare : tout peut potentiellement générer une alerte, et donc une suspicion.

Les questions éthiques et juridiques que soulève la surveillance algorithmique

Dès février 2025, sans attendre les conclusions complètes du rapport d’évaluation, le gouvernement a fait adopter un amendement, inséré dans la loi sur la sûreté dans les transports, prolongeant le dispositif jusqu’en mars 2027. La mesure, introduite en procédure accélérée et sans véritable débat public, a suscité de vives critiques. Plusieurs députés, inquiets de cette extension, ont saisi le Conseil constitutionnel le 24 mars 2025, estimant que ce prolongement faisait peser des risques sérieux sur les libertés fondamentales et relevait d’un cavalier législatif.

Sur le plan technique, le rapport d’évaluation, publié en février, soulignait pourtant les limites de maturité de la technologie : taux de faux positifs élevés, détection inégale selon les contextes, difficultés dans l’interprétation de certaines situations. Ces résultats n’ont pas freiné l’exécutif, bien décidé à ancrer la vidéosurveillance algorithmique (VSA) dans le paysage sécuritaire français.

En parallèle, des usages non couverts par la loi JOP ont vu le jour dans les collectivités locales, notamment via des logiciels comme Briefcam, utilisés pour analyser a posteriori les flux vidéo. Ce type de VSA en temps différé, destiné à accélérer les enquêtes policières, reste dans une zone grise juridique. Plusieurs tribunaux administratifs ont suspendu ces pratiques, mais d’autres, à l’instar du Conseil d’État, les ont partiellement validées, à condition qu’elles soient strictement limitées à un cadre judiciaire.

Cette évolution soulève une question démocratique cruciale : à quel moment une technologie, née sous couvert d’expérimentation temporaire, devient-elle un dispositif permanent, sans que les citoyens n’aient été réellement consultés ? Le risque est celui d’une normalisation silencieuse, dans un climat où les garanties constitutionnelles peinent à suivre le rythme technologique. Et à l’horizon, certains craignent déjà que la reconnaissance faciale ne soit la prochaine étape.

Photo Hans Lucas AFP

Enjeux techniques : promesses et limites

Les promoteurs de la surveillance algorithmique mettent en avant ses performances. Une caméra équipée d’IA peut, selon eux, détecter une anomalie en quelques secondes, et réduire drastiquement les délais d’intervention des forces de sécurité. Elle ne dort pas, ne cligne pas des yeux, ne subit pas le stress ou la lassitude. C’est une sentinelle numérique, froide et constante.

Pourtant, cette vision idéale se heurte à plusieurs limites techniques majeures. La première est celle de la précision des algorithmes. Si les systèmes de détection sont performants dans des environnements contrôlés, ils se montrent beaucoup plus faillibles dans la réalité. Des tests ont révélé des taux de faux positifs très élevés, notamment dans des conditions de faible luminosité, de météo dégradée ou en présence de foules compactes. Un algorithme peut confondre un sac de sport oublié avec un colis suspect, ou un regroupement d’étudiants avec une émeute en gestation.

Autre problème fondamental : les biais intégrés dans les algorithmes. Puisque les systèmes apprennent à partir de données passées, ils reproduisent les inégalités sociales et culturelles déjà présentes dans ces données. Si les images utilisées pour entraîner l’IA comportent une surreprésentation de certaines populations ou quartiers comme zones à risque, l’algorithme les surveillera davantage, renforçant les discriminations systémiques.

La question de l’infrastructure technique se pose également. Pour fonctionner efficacement, ces caméras nécessitent une connexion permanente à des serveurs puissants, souvent via des réseaux 5G, une capacité de stockage colossale, et des protocoles de cybersécurité renforcés. Or, le piratage de ces systèmes pourrait avoir des conséquences graves, allant de la divulgation d’images privées à l’activation malveillante d’alarmes.

Enfin, il faut déconstruire le mythe de la neutralité technologique. Un algorithme n’est jamais neutre : il reflète les choix de ceux qui l’ont conçu, les objectifs de ceux qui le financent, et les priorités de ceux qui l’exploitent. Derrière chaque caméra intelligente, il y a des décisions humaines, des stratégies politiques et des intérêts économiques.

Stratégies de contournement et résistances civiles face a la surveillance algorithmique.

Face à la généralisation des caméras intelligentes, des formes de résistance émergent, mêlant technologie, art et activisme. Des collectifs comme CV Dazzle développent des techniques de maquillage ou de coiffure capables de tromper les algorithmes de reconnaissance faciale. En jouant avec les ombres, les lignes, les contrastes et la géométrie du visage, ces artistes-activistes parviennent à rendre une personne « invisible » aux yeux d’une machine, tout en restant parfaitement identifiable pour un humain.

D’autres initiatives, comme celles du collectif Dazzle Club à Londres, organisent des déambulations urbaines avec des maquillages anti-surveillance. Leur but : attirer l’attention sur l’invisibilité des systèmes de contrôle, et redonner une forme de visibilité au débat public. Des vêtements spéciaux sont aussi développés, comme les anti-facial recognition hoodies, intégrant des motifs ou LED qui perturbent la lecture algorithmique.

Sur le terrain juridique et politique, certaines villes prennent position. San Francisco, berceau de la Silicon Valley, a interdit en 2019 l’usage de la reconnaissance faciale par les autorités municipales. En Europe, plusieurs ONG et associations de défense des droits numériques militent pour un moratoire sur la vidéosurveillance algorithmique, tant que des garanties démocratiques n’ont pas été mises en place.

Les hackers éthiques et experts en cybersécurité jouent également un rôle essentiel. Ils mènent des audits indépendants, démontent les failles des dispositifs en place, et alertent sur les risques de piratage, d’usurpation ou d’exploitation abusive. Dans un monde où la technologie avance plus vite que le droit, ces contre-pouvoirs deviennent indispensables.

Quelle société voulons-nous ?

La prolifération des caméras algorithmiques nous confronte à une question cruciale : quel équilibre voulons-nous entre sécurité et liberté ? Derrière l’efficacité promise par ces outils se cache une transformation plus profonde : celle de la relation entre le citoyen et l’espace public. Un espace où tout déplacement, toute interaction, tout comportement peut être mesuré, analysé, et archivé.

Les défenseurs de la surveillance avancent l’argument de la protection : mieux vaut prévenir un acte violent que le subir. Mais cette logique pousse à une forme de surveillance de masse par défaut, où tout le monde devient un suspect potentiel. Ce modèle, inspiré en partie par les régimes autoritaires, pourrait à terme érosionner les principes démocratiques fondamentaux, comme la présomption d’innocence ou la liberté de mouvement.

Des alternatives existent. On pourrait imaginer des systèmes de vidéosurveillance sous contrôle citoyen, avec des audits publics réguliers, des chartes éthiques transparentes et des possibilités de recours en cas d’abus. On pourrait exiger que chaque système algorithmique déployé dans l’espace public soit testé, certifié, et supervisé par une autorité indépendante. Des technologies dites « éthiques » sont aussi en développement, capables de détecter des situations à risque sans identifier les individus – par exemple, en analysant les dynamiques de foule plutôt que les visages.

Enfin, un débat de fond doit être posé : voulons-nous d’une société où la sécurité est assurée par la méfiance algorithmique, ou d’une société qui mise sur la participation, la prévention humaine et l’intelligence collective ? La technologie n’est pas mauvaise en soi, mais elle doit rester au service des choix de société, et non les imposer.